-

Compteur de contenus

2 995 -

Inscription

-

Dernière visite

Messages posté(e)s par Sethenès

-

-

Bah, pour la mémoire, je dirais : monitore. J'imagine que tu le fais pour tes applis, sous macOS, c'est pareil.

Exemple d'approche possible, tu démarres toutes les applis que tu as besoin en // (le plus) et puis tu supprimes 1 appli et tu vois combien de mémoire tu regagnes.

D'autre part, est-ce que Xcode, les émulateurs, etc. deviennent plus gourmands avec le temps ?

Pour le reste, je ne peux faire que me répéter. Si tu prends l'option 32 GB à 460 euros sur un 14", tu vas pratiquement payer 3x le prix du M1 d'entrée de gamme (x2,7) pour avoir les mêmes problèmes. Mais bon, quitte à payer 2,3x plus pour 16 GB alors autant payer 2,7x plus pour 32 GB.

Je termine quand même en précisant que je ne suis pas d'accord avec le point de vue de @Fred4. Après 27 mois (les Macs Mini de tests sont disponibles depuis mai 2020), il faut quand même envisager le fait que les choses ne s'arrangeront jamais.

-

Je suis de parti pris ... je crois que c'est assez clair. Conseiller est donc difficile.

Le M2 n'apporte pas grand chose à moins de faire de la programmation type AVX512 (Intel) dont un concurrent a été ajouté sur le M2. Or, il coute plusieurs centaines d'Euros de plus. Le gain de perf est marginal, sauf en multicœur mais pour faire du dev, des cœurs en plus n'apportent quand même pas grand chose.

Le M1 ... quoi qu'on en dise, il a 2 ans. Donc acheter un "gros" M1 aujourd'hui, c'est acheter une machine dont la durée de vie ( = durée du support OSX puisque tu as besoin du dernier Xcode) de 2 ans.

De plus, c'est clair, les M2 actuels sont des "entre deux" puisqu'Apple voulait à l'origine une meilleure finesse, qui arrive sur les modèles à sortir. Donc la question de la durée de support des M2 actuels doit quand même posée.

Une option, c'est d'attendre les nouveau M2 mais la note risque d'être très salée : finesse, modèle, up du prix du M2 par rapport au M1, inflation et taux de change Euro$ ... ça fait quand même un beau combo. Mais rien ne laisse penser que les softs tourneront mieux.

Pour moi, la bonne option, c'est l'achat du plus petit M1 possible (avec 16 GB). D'autant plus que dans cette logique (un PC + un Mac), le dev Android se fera sur le PC. Donc, sur le Mac, il ne faudra que Xcode est les autres outils qui vont bien pour faire de la programmation iOS ou macOS.

L'idée, c'est vraiment alors de faire l'achat "minimum". Est-ce que 512 GB (si tu ne fais que le dev iOSX dessus), est utile ? C'est encore 200 euros d'économisé.

-

C'est un peu triste à dire, mais cela me conforte dans ma position vis à vis des Apple Silicon. Ce sont de magnifiques machines, mais il faut absolument rester dans le monde d'Apple. Si on a d'autres besoins, c'est la galère.

Comment cela va-t-il évoluer ? Au fond, il y a 3 solutions : les problèmes vont diminuer, stagner ou s'amplifier.

Il faut quand même se rendre compte que les premiers M1 sont sortis il y a pratiquement 2 ans (novembre 2020, et encore car les Mac Mini de test datent eux de mai 2020 soit 27 mois). Tu es dev, poses-toi la question du temps que prends un portage digne de ce nom, surtout quand on dispose déjà du soft pour l'OS considéré car les softs dont tu as besoin existaient déjà certainement sous Mac Intel, autrement dit sur macOS.

Quel est la chance que soudainement les choses changent radicalement ? Et peu importe qui est responsable. Seul le résultat compte.

Pour ma part, je pense au contraire qu'au mieux les choses vont stagner. Parfois, tel jeu sortira nativement sous OSX, ou tel appli sera un peu mieux tunée. Mais en parallèle, d'autres applis ne seront pas/plus mise à jour.

Avec en plus, l'épée de Damoclès que représente la question du supporte de Rosetta II par Apple.

-

J'espère que tes backups sont en ordre ... sinon ...

-

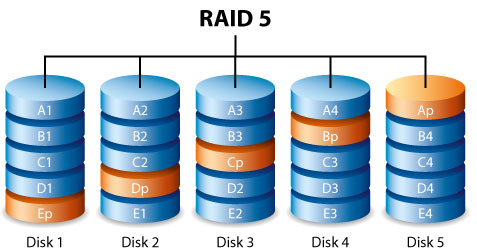

Regarde attentivement une configuration RAID 5 et imagine-toi le nombre de réécritures nécessaires : copier des données, recréation des régions de parités ....

-

Elle est là pour remplacer un disque qui montre des signes de faiblesse mais qui n'est pas encore tout à fait "foutu".

-

il y a 1 minute, LolYangccool a dit :

Mon RAID devrait passer de 40To à 32TO de stockage brut, et donc je perds 8To.

Mais je suppose que le système est suffisamment intelligent pour re-dimenssioner le volume de lui-même ?Ton RAID va passer en mode dégradé et va attendre un nouveau disque en remplacement.

Voilà quel sera le résultat !

-

Pourquoi est-ce que cette "fonctionnalité" est possible ? Quelle sera la conséquence sur le RAID ?

Quelle autre "incident" pourrait induire la même situation ?

-

Bien sûr ... mais si tu réfléchis bien ... que va-t-il se passer ?

-

Je ne pense pas que ce soit possible sans déconstruire le RAID. A voir avec les commandes "mdadm" de Linux qui permettent plus de choses.

Pour la question de débit, je ne sais pas. Au plus tu as de disques dans un RAID, au plus les performances sont bonnes, ce qui est assez logique. Donc, je ne sais pas si avec 2 SSD en RAID 0, tu auras de meilleures performances qu'avec 5 HDD en RAID 5. Il ne faut pas oublier que lors de la lecture, les 5 disques crachent chacun leur contenu. C'est en écriture, que les choses se compliquent.

-

il y a une heure, LolYangccool a dit :

Voilà... Donc un GPU tout juste sorti n'est pas utilisable à 100% de ses capacités sur les derniers jeux en date, sans mises à jour des drivers.

Certes, mais les premiers GPU pour M1 sont sortis il y a pratiquement 2 ans ...

Il ne faut pas oublier que lorsque les drivers sont mis à jour, c'est l'ensemble des cartes d'une même génération qui profite de la mise à jour. Que celle-ci soit sortie plus tôt ou plus tard, ne change rien. Si Nvidia met à jour ses drivers pour les cartes Ampère, ce sont toutes les cartes de la RTX 3050 à la RTX 3090 TI qui en profite.

Donc en toute logique, si les drivers fonctionnent correctement sur les MBA M1, ils doivent faire de même sur les Mac Studio M1 sortis récemment.

-

"Ma" logique, j'insiste, c'est d'essayer d'être le plus "défensif" possible avec mes NAS.

Si au taf, on payait une société tierce pour héberger nos backups (en fait, c'était plus une synchronisation via un mécanisme de snapshot qu'un "vrai" backup), société qui en plus contrôlait les backups, chez moi, toute cette "responsabilité" repose sur mes seules épaules.

Et je suis loin d'opérer un contrôle journalier. Du coup, comme je l'ai expliqué, j'essaie d'être le plus défensif possible au travers notamment du choix du RAID 6 et d'un disque "spare". Evidemment, la facture s'alourdi puisque cela revient à avoir 3 unités disques indisponibles pour les données.

"Mon" sentiment par rapport aux SSD, c'est qu'ils fragilisent la solution. Je cite le contenu d'une page de l'aide de Synology : "RAID F1 applique le mécanisme de RAID 5 (...). Toutefois, avec RAID F1, le système écrit davantage d'informations de parité sur un disque spécifique afin d'accélérer son vieillissement et, par conséquent, d'éviter que tous les disques n'arrivent simultanément en fin de vie.(...). RAID F1 est idéal pour les matrices exclusivement en flash."

C'est pour ça que je suis pas très enthousiaste. On le sait, le RAID occasionne plus de problèmes qu'une solution sans RAID (puisqu'il y a plus d'écritures et plus de lectures) - mais - en revanche, le RAID diminue les conséquences des problèmes. Et ce, à condition bien sûr qu'il soit bien géré (ex : si le RAID est dégradé, le disque défectueux est immédiatement remplacé).

Donc SSD ... OK mais alors il faut réévaluer les autres éléments de la solution : le backup est-il assez robuste ? RAID 6 ? Disque spare ? Autre mécanismes à considérer ?

Source : https://kb.synology.com/fr-fr/DSMUC/help/DSMUC/StorageManager/storage_pool_what_is_raid?version=

-

Oui, c'est le but. J'imagine que les drivers sont "aussi" optimisés pour les programmes "pro" les plus répandus (suite Adobe, ...) et ce, dès la sortie du GPU.

D'autre part, c'est probablement le cas aussi pour les usages via "METAL" ou pour Nvidia, les usages CUDA. On n'en parle moins que la mise à jour des drivers pour les jeux, mais ce n'est pas pour ça que le job n'est pas fait.

-

Pour moi il y a 2 soucis majeurs. Le premier, c'est le SATA III. Le gain entre un SSD et un HDD ne me parait pas suffisant pour justifier le prix.

Le second est que les SSD s'usent visiblement beaucoup plus vite. D'ailleurs, Synology a récemment (quand ?) mis en place une nouvelle manière d'utiliser les SSD pour en "sur"-utiliser certains et en "sous"-utiliser d'autres, de manière à échelonner le calendrier de remplacement des disques.

-

Il y a 5 heures, LolYangccool a dit :

Dire qu'une machine va planter parce qu'elle a trop de ressources pour l'utilisation, c'est quand même osé.

Ca voudrait dire, selon ce vendeur, qu'il faut toujours utiliser la machine au maximum de ses capacités sinon elle plante ?

On aura tout vu ici...Je confirme. L'argument est faux. Avoir beaucoup, mais alors beaucoup trop de mémoire peut causer une légère perte de performance, mais on ne parle pas de 8 ou de 16 GB, mais de 100x plus.

8 GB n'est pas "a priori" un mauvais choix, mais il faut avoir une utilisation raisonnable de la machine. 16 GB, c'est quand même mieux, surtout pour la pérennité de la machine.

Le problème, c'est le prix de l'upgrade. 230 euros (prix Apple), c'est quand même très cher. A 59 euros, je conseillerais à tout le monde de prendre 16 GB. A 230 ...

-

J'imagine que tu es tombé sur cette discussion : https://community.synology.com/enu/forum/67/post/139152?page=1&sort=oldest ?

-

J'imagine que tu ne vois pas de process non plus ?

As-tu essayé de lancer l'exe au départ d'un shell ?

As-tu tenté un sudo ?

-

Votre bureau

dans Divers

Attention, il y a des aimants permanent dans les baffles.

-

Par souci d'honnêteté, je me présente. Je suis un déçu de certains produits Apple, mais surtout de la politique de cette société.

Ceci dit, je pense avoir raison quand je dis qu'avec Apple, tu as tout intérêt à utiliser leurs produits comme ils veulent que tu les utilises. Sans ça, tu vas au devant de (mauvaises) surprises à court ou à moyen terme car ils n'hésiteront pas à supprimer (et sans avertissement) tout ce qu'ils considèrent comme "non" canonique.

Si avec le Mac, il y a encore une certaine liberté, c'est nettement moins le cas sur iPad. Plus encore, au plus tu entreras dans l'écosystème Apple, au plus tu seras pieds et poings liés. Un simple exemple : il est impossible de réinstaller une version antérieure d'iOS une fois que tu as installé la nouvelle. Donc même si une fonctionnalité ne te convient pas, tu ne pourras pas revenir en arrière. Et même si tu parvenais à le faire, tout est mis en œuvre pour te forcer à avoir les dernières versions d'OS sur tout tes appareils Apple.

Ce n'est pas fortuit, c'est voulu. Cela figure en toute lettre dans le mail-"testament" de Steve Jobs envoyé à ses troupes un peu moins d'un an avant sa mort, je cite :

Qui peut se traduire (libre) part : "lier tous nos produits ensemble afin de mieux verrouiller les clients dans notre écosystème.

Je crois que cela a le mérite d'être clair.

-

Le 28/03/2021 à 09:13, Sethenès a dit :

Ce que j'analyserai, ce sera :

- Le différentiel de puissance à nombre égal de cœur, ce qui devrait donner une idée de la marge dont dispose la technologie ARM (évidemment croisé avec d'autres données : fréquence, consommation). Analyse à réaliser tant pour le CPU que pour le GPU, il va sans dire.

- L'évolution dans l'intégration des composants. C'est l'une des question ouverte. Le concept d'Apple est-il mûr ou au contraire, va-t-il encore évoluer significativement à court terme (avec évidemment en ligne de mire, la vitesse d'obsolescence des premiers modèles sortis).

- La communication entre le "SOC" et le reste du monde. Pour le moment, il y a quand même eu un sérieux coup de frein de ce côté : pas de GPU dédié, pas d'eGPU, perte de l'option réseau 10 Gbit/s sur le Mac Mini. Alors je suis d'accord pour dire que ces options sont pour certaines très dispensables, mais comme il s'agit d'une régression, la question peut être posée. Vont-ils étendre les échanges avec le SOC ou pas, vont-ils sortir certains composants comme le GPU par exemple ?

- Y aura-t-il encore la possibilité de modifier la mémoire ou le SSD (en particulier sur les iMacs les plus haut de gamme).

- Quel sera le reliquat de machines non migrées vers ARM (je pense par exemple au Mac Mini i5 qui est toujours au catalogue) et si possible d'essayer d'en comprendre la raison.

Source : https://forum.macbidouille.com/index.php?s=&showtopic=420072&view=findpost&p=4376534

Le 28/03/2021 à 16:26, Sethenès a dit :(complément à l'analyse) :

- Est-ce que le ratio performance / coût restera le même ?

Je m'explique. Apple a marqué les esprits avec une approche très intéressante en terme de perfomance / Watts mais en même temps, elle a été très raisonnable sur l'aspect financier. Maintenant que les esprits sont conquis, Apple va-t-elle restée aussi généreuse ou au contraire va-t-elle progressivement remonter les prix ?

Le 30/03/2021 à 20:09, Sethenès a dit :J'apporte une précision pour la première axe d'analyse. L'un des éléments clé sera la performance mono-cœur bien sûr. C'est son évolution, compte-tenu des variations éventuelles de fréquences et de consommation qui seront, pour moi en tout cas, vu comme un indicateur de ce que cette technologie a comme potentiel futur.

Un exemple concret : si la performance mono-cœur gagne 20% mais que la fréquence est 20% plus élevée, de même que la consommation, cela montre simplement le potentiel de la génération 1 de la puce. Le gain, entre les versions 1 et 1+ ou 2 se mesureront au contraire en neutralisant les effets de fréquences et (dans une moindre mesure certes) de consommations.

Y avait de l'idée, non ?

-

Il y a 12 heures, pehache a dit :

Oui... Après ils étaient déjà engagés dans les processeurs ARM depuis les débuts de l'iPhone, ils n'ont peut-être pas voulu tout changer non plus. Note qu'à ma connaissance toutes les unités de calcul autres que le CPU (GPU, NPU,...) sont entièrement de leur cru.

Cela change(rait) fortement la donne, effectivement.

J'ai un peu cherché et je trouve l'info qu'Apple a utilisé pour l'iPhone 4S, un GPU de la marque PowerVR.

Source : https://www.anandtech.com/show/4971/apple-iphone-4s-review-att-verizon/6

Source : https://www.notebookcheck.net/PowerVR-SGX540.115806.0.htmlAprès un peu plus de fouille, je trouve ceci concernant l'A10 : "Further analysis has suggested that Apple has kept the GT7600 used in Apple A9, but replaced portions of the PowerVR based GPU with its own proprietary designs.".

C'est à partir de la puce A11, que la dénomination "Apple-designed three-core graphics processing unit (GPU)" apparait.

Donc disons que le "entièrement" de ton intervention d'hier me parait à tout le moins un peu exagéré. Le tout serait de savoir si Apple paie une licence / redevance à PowerVR ou pas.

Source : https://en.wikipedia.org/wiki/Apple_A10

Source : https://en.wikipedia.org/wiki/Apple_A11Pour le NPU, je trouve ceci (même source que précédemment) : "Bloomberg says that the neural engine is the fruit of Apple's efforts to improve its AI team, since the 2015 report by Bloomberg that Apple's secretive nature made it difficult to attract AI research scientists.[16] Apple has since recruited people and multiple companies working on AI, and has published papers related to AI research.[16] In October 2016, Apple hired Russ Salakhutdinov as its director of AI research.".

Ici, je ne trouve aucune "antériorité" faisant référence à une "paternité" externe comme base de la puce (ou du morceau de puce) d'Apple.

-

il y a 48 minutes, pehache a dit :

Pour ce que j'en comprends, ARM ce n'est pas grand chose de plus que des spécifications pour un jeu d'instructions. Concevoir un hardware qui implémente ce jeu d'instructions ça demande du savoir-faire...

Si ce n'était que ça, pourquoi Apple n'aurait-elle pas simplement inventer un jeu d'instruction et les specs qui vont avec. Et là, ils maitrisaient tout le "pipe".

Je ne pense que Nvidia, qui rappelons-le maitrise ces technologies en partie du moins, aurait tenté de s'emparer d'ARM si la valeur ajouté était si faible.

Et pour les keynotes, je suis assez d'accord. J'ai un iPad mini et je trouve son OS adapté. Par contre dès lors qu'ils ont voulu vendre des iPads "Pro", dans le sens de tablette non convertible qui puisse remplacer un laptop classique, il fallait que l'OS propose les mêmes fonctionnalités que l'OS d'un laptop.

En ce sens, les "avancées" récentes ne sont finalement qu'une série de reculs sur des mauvaises décisions antérieures, décisions purement dogmatiques.

-

Il y a 16 heures, pehache a dit :

Ce que je vois quand même c'est que jusqu'à maintenant les laptops qui ont des perfs comparables à un MBA M1 (et maintenant M2) ont toujours des ventilateurs. Le core i5-1235U par exemple a une TDP de 55W quand il est sollicité à fond.

Pour les GPU Apple en a profité pour changer de paradigme avec des GPU intégrés dans tous les cas.

C'est vrai.

Mais il y a ici un subtil glissement. ARM, jusqu'à preuve du contraire n'est pas une technologie Apple, en ce compris les GPU des processeurs ARM.

C'est d'ailleurs un point que j'ai difficile à intégrer, c'est que ce qu'Apple fait de ARM, les autres ont (ou auraient) tant de mal à le refaire. Et d'ailleurs, il n'a échappé à personne que plusieurs collaborateurs ont été récemment débauché par la concurrence. C'est un peu le risque qu'Apple prend en utilisant une technologie tierce, qui de surcroit à un businness model fondé sur la licence d'utilisation. Et il est clair que depuis l'échec de Nvidia à racheter ARM, Apple ne pourra pas les racheter non plus.

Donc oui, force est de constater qu'ils tirent le meilleur de ARM, mais ARM ce n'est pas une technologie Apple !

-

Et surtout, le plus important est d'avoir un bon backup ... et surtout de ne pas faire confiance à Time Machine comme seul outil de backup.

Equipement conseillé pour développement mobile iOS + Android : RAM, Intel vs M1...

dans Conseils d'achat

Posté(e)

Tout d'abord, je reviens un moment sur ta méthodologie du test mémoire. Remarque que j'avais suggéré de fonctionner de la manière suivante : 1/ "tout" démarrer (et mesurer l'usage). 2/ fermer 1 appli et mesurer la différence. 3/ Faire cela pour toutes les applis.

Pourquoi ce test précisément ? Parce que cela va te donner une idée de la mémoire réellement utilisée par l'appli en question.

Ensuite, il se trouve que j'ai soumis une appli pour iPad en 2011. Ca date, mais je vois quand même un peu le principe. As-tu souvent besoin des deux émulateurs ouverts en même temps ? Pour les environnements de développement, ça OK, je comprends. Pour comparer les codes entre eux, faire éventuellement des copier/coller. Mais les émulateurs ?

Au fond, c'est ça la question. Combien de fois par an vas-tu être ennuyé ? Si c'est 1 h par an et que tu tiens ta machine 4,6 ans ... bah ça te coute 460 / 4,6 h = 100 euros de l'heure. Si par contre, c'est 1h par jour, amorti sur 2 ans (comptons 230 j de travail par an), l'upgrade de 16 à 32 GB vas te couter 1 euro de l'heure (460 / (2x230)).